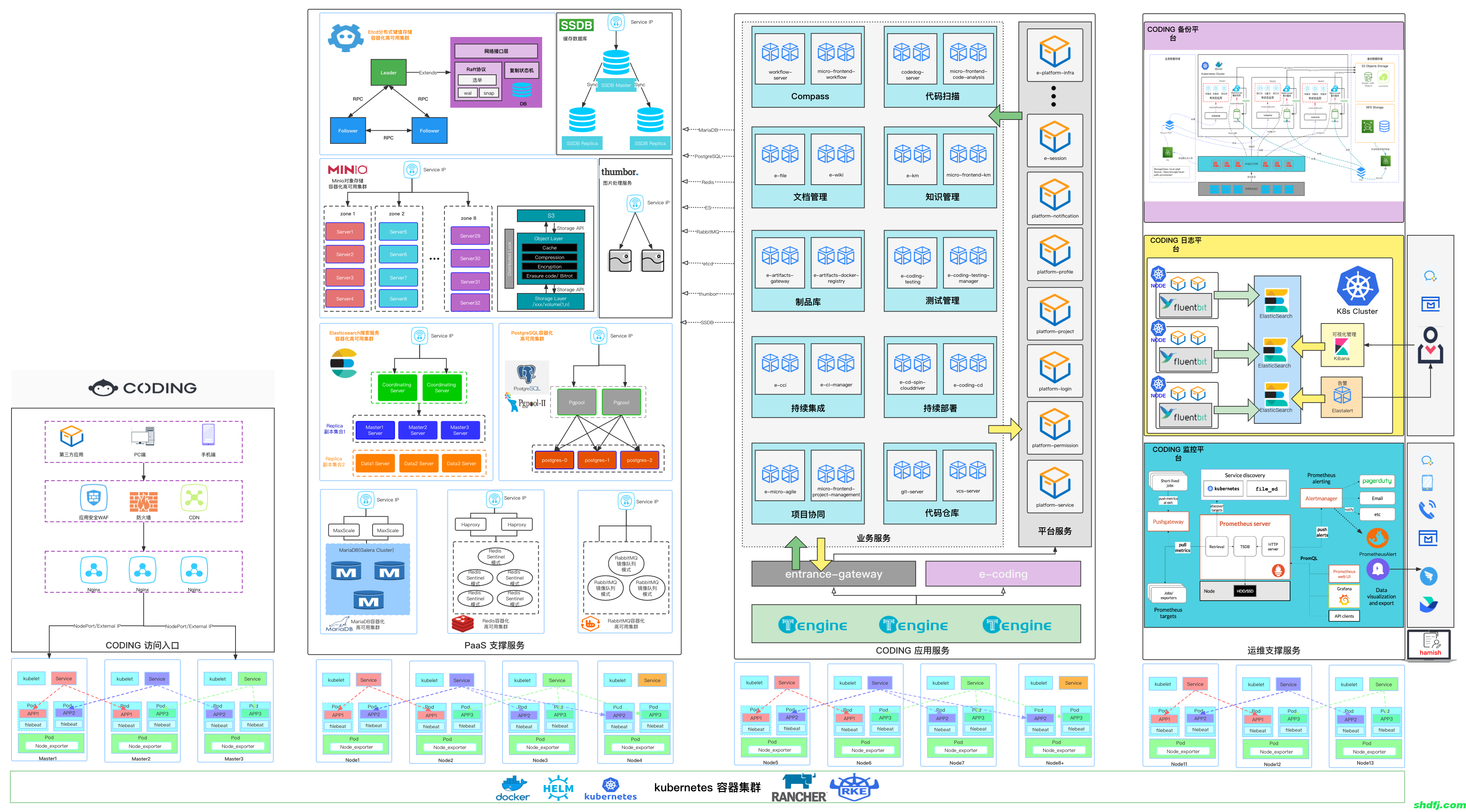

标准化 CODING K8S 底座 PaaS 平台解决方案

1、需求背景

试想下传统的后端部署办法:把程序包(包括可执行二进制文件、配置文件等)放到服务器上,接着运行启动脚本把程序跑起来,同时启动守护脚本定期检查程序运行状态、必要的话重新拉起程序。

有问题吗?显然有!最大的一个问题在于:如果服务的请求量上来,已部署的服务响应不过来怎么办?传统的做法往往是,如果请求量、内存、CPU超过阈值做了告警,运维马上再加几台服务器,部署好服务之后,接入负载均衡来分担已有服务的压力。

问题出现了:从监控告警到部署服务,中间需要人力介入!那么,有没有办法自动完成服务的部署、更新、卸载和扩容、缩容呢?

这,就是K8S要做的事情:自动化运维管理Docker(容器化)程序。

2、部署模式

(1)独立部署(生产环境)

生产环境强烈建议独立节点部署,需要为底座中间件 Middleware 应用提供专属的 K8s Worker 节点,需要对专属节点打污点/标签隔离区分,后面部署过程会介绍污点和标签的详细操作;

(2)混合部署(测试环境)

测试环境没有足够的节点时,可以和业务服务混部,不需要打污点和标签。

默认中间件全局部署配置为 soft 软亲和,如需独立部署请根据后面的配置指引设置为 hard 硬亲和

3、资源需求

建议提供不少于 5 台专属 k8s worker 节点,和业务隔离计算节点部署,单台服务器配置如下:

(1)CPU: >= 16核

(2)内存:>= 64G

(3)系统盘:>= 100G

(4)数据盘(/data):>= 2T

4、K8S的解决方案

K8S是属于主从设备模型(Master-Slave架构),即有Master节点负责核心的调度、管理和运维,Slave节点则在执行用户的程序。

在K8S中,主节点一般被称为Master Node或者Head Node(我们采用Master Node称呼方式),而从节点则被称为Worker Node或者Node(我们采用Worker Node称呼方式)。

5、K8S的系统结构